L’arrivée des IA génératives (IAg1) suscite de nombreux débats dans l’espace public et dans différents milieux professionnels qui s’interrogent sur leurs risques et leurs potentialités. Un lieu commun revient régulièrement dans ces discussions : une IAg serait « juste un outil »2. Cette affirmation s’inscrit dans une vision dite « instrumentale » de la technique, qui draine avec elle plusieurs présupposés : dans le sens commun, un « instrument » est un objet « neutre » qui reste sous le « contrôle » de son utilisateur et dont les effets ne dépendent que de l’usage qu’on en fait. Dans le cadre des débats sur les IAg, cette vision instrumentale et les discours qui la véhiculent produisent de puissants effets de cadrage : ils concentrent la réflexion sur les seuls usages finaux et tendent à invisibiliser de nombreux aspects cruciaux dont il est pourtant nécessaire de tenir compte si l’on souhaite penser les effets de ces technologies dans toute leur complexité.

Ce texte propose de caractériser ces effets de cadrage, ceux-ci se situant principalement sur deux plans. Le premier plan concerne l’effacement des « conditions de possibilités » de ces technologies, c’est-à-dire l’invisibilisation – en particulier auprès de leurs utilisateur·ices – de l’ensemble des dispositifs matériels et sociaux nécessaires à leur usage. Le second plan concerne l’occultation de la manière dont ces technologies transforment et structurent la société. La vision instrumentale, qui repose sur le postulat que les utilisateurs conservent en dernière instance la maîtrise et le contrôle sur les technologies, ne tient pas compte des contraintes sociales qui s’exercent sur les individus et orientent leurs usages.

Précisons que l’enjeu de la réflexion n’est pas ici terminologique ou conceptuel : le terme de technologie a été choisi pour désigner les « techniques » en général, du marteau à l’IA, en passant par l’automobile. Le terme d’« outil » est quant à lui réservé pour citer l’utilisation qui en est faite – et que ce texte critique – dans les débats sur les IAg.

Enfin, parce qu’il est souvent frustrant de se sentir démuni·e face à ces discours qui nous invitent à « ne pas s’inquiéter, car c’est juste un outil » dès lors qu’on émet la moindre réserve sur ces technologies, ce texte a également pour objectif d’apporter quelques arguments pour y répondre.

L’écrasement des différences

Commençons par une observation : le déploiement d’une technologie ne s’accompagne pas systématiquement d’un discours instrumentaliste. Si cette idée est répétée avec tant d’insistance au sujet des IAg, c’est précisément parce que leur arrivée suscite de nombreux débats, et plus encore des inquiétudes, que l’argument instrumentaliste cherche à désamorcer. Rabattre cette technologie bien particulière dans le champ général et indifférencié des « outils » permet de circonscrire la réflexion dans un cadre connu et donc rassurant. « C’est juste un outil » : sous-entendu « comme les autres », « n’ayez pas peur ».

Il faut pourtant rappeler cette évidence : tous les « outils » ne sont pas de même nature. Les technologies reposant sur de vastes infrastructures matérielles en réseau3, les techniques ayant le pouvoir d’augmenter de façon considérable la portée et la puissance de l’agir humain4, les machines assurant des tâches complexes en ne requérant qu’une supervision, etc. ne peuvent pas être pensées dans les mêmes termes qu’un outil comme, par exemple, un marteau.

Le raisonnement selon lequel « l’IA ne serait qu’un outil », revient pourtant à mettre sur un même plan le couteau à pain, le smartphone, l’avion, le marteau, Internet, la bombe atomique et la brosse à cheveux. Un tel écrasement des différences entre ces technologies constitue déjà un premier effet de cadrage, car ce qui les différencie est à bien des égards plus déterminant que ce qui les rassemble.

Le raisonnement selon lequel « l’IA ne serait qu’un outil » revient à mettre sur un même plan le couteau à pain, le smartphone, l’avion, le marteau, Internet, la bombe atomique et la brosse à cheveux.

L’occultation des conditions de possibilité de l’IAg

Les différences entre un simple outil, comme par exemple un marteau, et une IA générative apparaissent en effet clairement dès lors qu’on examine leurs conditions de possibilités respectives, c’est-à-dire l’ensemble des matériaux, des infrastructures, des institutions, des pratiques sociales, etc. tout ce qui est nécessaire à l’existence de ces technologies.

Dans une économie mondialisée, l’analyse des conditions de possibilité d’un simple marteau fait immédiatement intervenir de nombreux acteurs répartis en différents coins du globe. Pour autant, l’empreinte matérielle de cet outil demeure limitée et ses conditions sociales de production sont tout ce qu’il y a de plus ordinaire. De surcroît, la production et l’utilisation d’un marteau serait possible dans une économie localisée.

Ce n’est clairement pas le cas des objets numériques. En effet : quelles sont les conditions de possibilité d’une IAg, telle que ChatGPT ?

L’inventaire peut commencer par les datacenters, dont les constructions se multiplient afin d’accueillir le déploiement de ces technologies5, aboutissant à une croissance vertigineuse des besoins en électricité6. Ces nouvelles infrastructures drainent avec elles des réseaux de télécommunication7, des usines de production de composants électroniques, des mines8, etc. Si la matérialité de l’IA et du numérique en général9 est une réalité dont on prend progressivement conscience10, cette préoccupation se réduit bien souvent à une simple invitation à un usage « réfléchi », dont on observe l’inefficacité à infléchir les trajectoires insoutenables de l’impact environnemental du numérique.

Car dans le même temps, les entreprises du secteur tablent de leur côté sur une croissance exponentielle des usages. En effet, dans l’inventaire des conditions de possibilités de ChatGPT ne figure pas seulement ce qui lui permet de fonctionner, mais également ce qui a permis de le mettre au point : des milliards de dollars11 investis en salaires d’ingénieurs en IA, en infrastructures de calcul pour entraîner les modèles, en activité de R&D pour développer des calculateurs ad hoc12, etc.

Ces investissements ont été réalisés dans une perspective de rentabilité. Or, s’il n’est pas sûr que les profits escomptés par les acteurs de la Big Tech se traduisent en croissance économique13, cette situation participera nécessairement à donner forme au déploiement futur de l’IA, malgré tous les éventuels appels à la modération ou au discernement.

À cela s’ajoute l’exploitation humaine pour l’entraînement et la modération des modèles14 : des millions de personnes vivant essentiellement dans des pays du Sud sont payées quelques centimes de dollar pour labeliser des données. Comme le dit Sébastien Broca, « sans la globalisation des chaines de valeur et la persistance de logiques néocoloniales, l’IA générative n’existerait pas »15.

Lire aussi sur Terrestres : Hélène Tordjman, « Économie numérique : la mue du capitalisme contemporain », mai 2021.

Il faut également tenir compte du pillage d’une immense quantité d’œuvres protégées par droits d’auteurs16, sans oublier les données d’interaction avec les IAg, dont chaque utilisateur autorise qu’elles puissent contribuer à son apprentissage. Chaque utilisation individuelle de ChatGPT repose sur cet ensemble de conditions, sociales et matérielles.

Cet inventaire pèse déjà lourd, excessivement plus lourd qu’un marteau. On doit pourtant élargir encore le champ de l’analyse pour qu’elle soit complète. Il est logique d’intégrer dans les conditions de possibilité des IAg l’Internet et le numérique en général. C’est en effet uniquement parce que le numérique a pris cette place centrale dans nos sociétés, parce que ses infrastructures sont répandues de manière si diffuse, parce qu’Internet s’est trouvé être le réceptacle d’autant de données et de « connaissances », parce qu’une part toujours plus grande du monde est numérisée, que les IAg ont pu être développées.

Planter un clou avec un marteau n’engage physiquement que l’utilisateur du marteau, le clou et le support. Effectuer une requête sur ChatGPT mobilise au contraire une gigantesque infrastructure.

Enfin, pour souligner l’incommensurabilité, notamment sur le plan matériel, entre les IAg et un simple marteau, on peut également délimiter le périmètre physique de leur usage. Planter un clou avec un marteau est une action qui n’engage physiquement que l’utilisateur du marteau, le clou et le support sur lequel celui-ci est planté. Effectuer une requête sur ChatGPT, mobilise au contraire une gigantesque infrastructure faite de logiciel, de réseaux et de calculateurs : un système complexe.

Dire comme on l’entend souvent qu’une IAg « c’est juste un outil » a donc pour effet d’invisibiliser la majeure partie des dispositifs matériels et sociaux qui soutiennent ce qu’il paraît plus approprié de qualifier de « système ».

L’occultation des effets de structuration sociale par les IAg

La vision instrumentale de la technique considère que les effets d’une technologie sont intégralement déterminés par les usages qu’en font les individus. Elle part du principe que si personne n’utilisait une technologie, celle-ci n’aurait aucun effet et tendrait à disparaître17. Appliqué au domaine des IAg, ce raisonnement s’accompagne du discours selon lequel les IAg ne sont in fine que ce que l’on en fait et que le principal, sinon l’unique sujet sur lequel il faudrait s’accorder concerne la distinction entre les « bons » et les « mauvais » usages.

Pourtant, plusieurs arguments tendent à montrer que les effets sociaux des IAg – et c’est le cas de nombreuses autres technologies – ne sont pas seulement la somme des effets des usages individuels. Dit autrement, penser les effets sociaux de l’IAg par le seul prisme de ses usages conduit à occulter les mécanismes par lesquels la société toute entière se transforme sous l’effet d’une technologie.

La dépendance au sentier

L’histoire du déploiement progressif de l’automobile fournit une excellente illustration de ces mécanismes. Ce déploiement s’est accompagné du développement de nombreuses infrastructures, autant matérielles (les routes, les réseaux de transports de pétrole, etc.) que socio-économiques (l’industrie automobile, l’industrie pétrolière, les banlieues résidentielles, etc.) selon un principe d’auto-renforcement : le développement des infrastructures vient structurer les modes de vie autour de cette technologie, engendrant une forme de dépendance sociale qui contribue à son tour à accroître le développement de ces infrastructures.

La notion de dépendance au sentier est employée pour décrire ce phénomène, soulignant comment des déploiements techniques passés ont un effet structurant sur le futur des sociétés : le futur d’un système socio-technique est déterminé par la trajectoire qu’il a suivie dans le passé.

La question du bon et du mauvais usage individuel de la voiture n’a aujourd’hui pas vraiment de sens : cet usage est en partie imposé.

En donnant forme à un monde adapté à l’automobile, celle-ci s’est rendue incontournable pour ce monde-là et nos sociétés en sont devenues dépendantes, entraînant un effet de verrouillage socio-technique. Dans ce contexte, l’automobile n’est dès-lors plus un simple instrument que les individus auraient le libre choix d’utiliser ou non. Par conséquent la question du bon et du mauvais usage individuel de la voiture n’a aujourd’hui pas vraiment de sens : une partie de cet usage est imposée et pour celle-ci on n’a pas le loisir de se demander s’il est bon ou mauvais.

Le numérique est également un parfait exemple d’une technologie se déployant selon un processus de dépendance au sentier. Son omniprésence dans nos sociétés est le résultat d’une trajectoire qui a vu se développer progressivement les infrastructures de télécommunication et les terminaux (ordinateurs, smartphone, etc.) au fur et à mesure que les usages se multipliaient et s’encastraient dans les modes de vie et les pratiques sociales, modifiant les manières de s’informer, de communiquer, d’étudier, de travailler, de se distraire, etc., selon un mécanisme d’auto-renforcement.

Lorsque des seuils de déploiement ont été franchis, certaines activités du quotidien n’ont plus été possibles que par la médiation du numérique, engendrant un verrouillage socio-technique. On peut penser aux ENT (Espaces Numériques de Travail), qui se sont imposés dans les collèges et lycées pour accéder par exemple aux devoirs, sans possibilités de contournement18.

L’IA en général, et les IA génératives dont il est plus particulièrement question dans ce texte, constituent un prolongement de la trajectoire socio-technique du numérique : c’est parce que le numérique imprégnait nos sociétés et leurs organisations19 que les IAg ont pu être développées et qu’elles se déploient avec une telle rapidité. Pour que cela ait lieu, il était en effet a minima nécessaire que les données d’apprentissage soient disponibles sur Internet et que l’usage d’applications sur smartphone ou par Internet fassent partie des habitudes sociales.

Comment les IAg peuvent devenir incontournables

La question que l’on peut alors se poser est de savoir quelle dépendance au sentier vont engendrer les IA génératives : quelles formes prendront les mécanismes d’auto-renforcement ? Pour quelles pratiques sociales leur usage deviendra-t-il incontournable ?

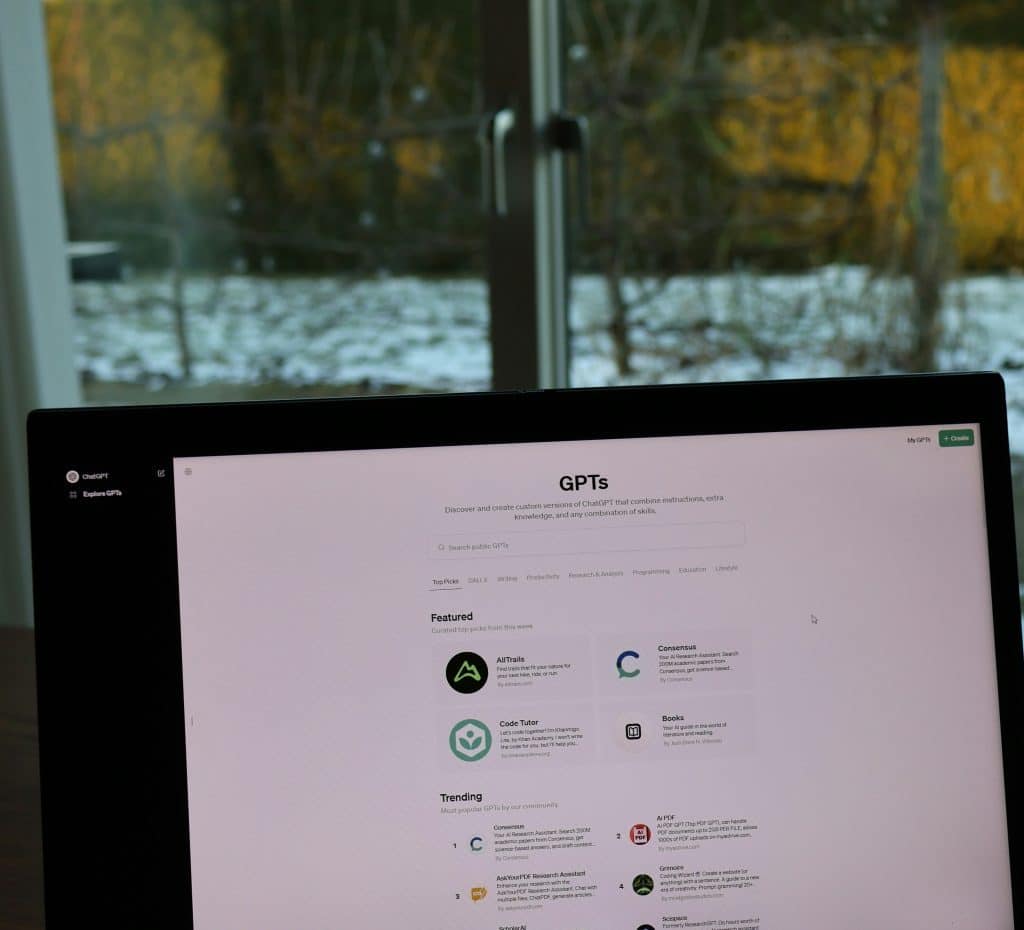

Une illustration de cette logique d’auto-renforcement s’observe actuellement dans les débats sur l’usage des IAg dans l’enseignement supérieur. Au motif que les étudiant.es les utilisent de toute façon déjà, mais surtout que ces « outils » seront communément utilisés dans leur future activité professionnelle, on voit se multiplier les formations, à destination des étudiant.es et des personnels enseignants, pour intégrer les IAg dans les pratiques pédagogiques et pour maîtriser « l’art du prompt20 ». Cette préoccupation, parfaitement légitime au demeurant, qui vise à doter les étudiant.es des compétences qui leur seront nécessaires car elles seront devenues incontournables, contribue de manière certaine à rendre l’usage de ces technologies effectivement nécessaire et incontournable. Dit autrement, ce qui rend véritablement inéluctable le déploiement d’une technologie, c’est la croyance partagée dans son aspect inéluctable.

Lire aussi sur Terrestres : Atécopol, « Les impacts écologiques de la G5 », juillet 2022.

Concernant le caractère incontournable des IAg, sans s’essayer à des prédictions hasardeuses, l’histoire récente du numérique, et notamment les effets de verrouillages socio-techniques qui se sont produits lorsque des seuils de généralisation de l’usage ont été franchis, peut nous donner quelques indices de ce qui pourrait advenir. Ce caractère incontournable pourrait prendre une forme stricte, l’usage de l’IAg étant nécessaire pour réaliser une activité : si par exemple l’unique moyen de communication avec un service commercial ou administratif est un Chatbot, et qu’il n’est proposé aucune possibilité de contournement. Il pourrait également s’agir d’une forme moins stricte : si tout le monde (ou presque) utilise une IAg, ne pas l’utiliser devient trop pénalisant et on finit par l’utiliser. Ce dernier cas, qui est de loin le plus répandu, échappe presque par définition à la vision instrumentale, car celle-ci ne tient pas compte des effets que produisent les usages d’une technologie sur… celles et ceux qui ne l’utilisent pas (encore) !

Ce qui rend véritablement inéluctable le déploiement d’une technologie, c’est la croyance partagée dans son aspect inéluctable.

Si les élèves d’une classe sont autorisés à utiliser ChatGPT pour « chercher des idées » ou « améliorer leur texte » dans le cadre d’un devoir à rendre dans un temps fortement contraint, un élève qui ferait le choix de se passer de ChatGPT serait de facto pénalisé. À partir du moment où ChatGPT est autorisé, il tend à devenir incontournable.

Si au sein d’un service d’une entreprise ou d’une administration, l’usage de l’IAg se généralise pour assister les employés dans les tâches de rédaction de rapports de type formel, car il est constaté que cela fait gagner du temps sans que les destinataires ne s’en plaignent, alors le standard de productivité au sein de ce service se trouve de facto redéfini. Une personne qui désirerait éviter de recourir à l’IAg serait moins productive que les autres. Elle pourrait finir par être contrainte de l’utiliser afin de se conformer au standard de productivité demandé.

Il existe une immense variété de pratiques sociale dont la norme sera ainsi progressivement modifiée par la généralisation des usages de l’IAg. On peut d’ailleurs remarquer que dans une société valorisant la productivité (autant dans la sphère économique que dans la sphère individuelle), le déplacement de la norme sociale sous l’effet des IAg sera globalement orienté dans une unique direction : celle qui laisse escompter les gains de productivité les plus grands.

C’est la multiplication des situations dans lesquelles les IAg deviennent incontournables – que cela soit de manière stricte ou parce qu’il devient trop pénalisant de ne pas les utiliser – qui contribue à engendrer ce phénomène de dépendance sociale et ce mécanisme de dépendance au sentier.

Une dépendance à l’IA qui reste encore essentiellement à venir

L’une des raisons pour lesquelles l’argument affirmant que « l’IAg c’est juste un outil » peut être martelé sans rencontrer de forte opposition réside dans la relative nouveauté de cette technologie.

Si tout le monde peut aisément mesurer aujourd’hui combien l’automobile a radicalement transformé les modes de vie, les paysages, l’urbanisme, etc., ces bouleversements ne se sont pas faits en un jour. La dépendance de nos sociétés au « tout voiture » est le fruit d’un processus qui s’est étalé sur plusieurs dizaines d’années.

En comparaison, nous n’en sommes encore qu’au tout début des IAg21 et certains arguments soutenus par la vision instrumentale peuvent à l’heure actuelle difficilement être démentis. En effet, malgré les diverses incitations à utiliser les IAg et à s’y former dans le milieu professionnel, elle n’est pas une technologie incontournable : on peut légitimement avoir le sentiment qu’on est libre de l’utiliser ou non.

C’est pourquoi il faut insister sur l’idée que ce qui peut sembler aujourd’hui n’être « qu’un outil comme un autre » (si l’on fait abstraction des conditions de possibilités, ce qui n’est pas rien) est à l’évidence voué à transformer radicalement les modes de vie, à structurer de nombreuses pratiques sociales autour de son utilisation et à engendrer un puissant phénomène de dépendance au sentier, d’une manière que les usages actuels ne laissent en rien présager. Les analyses des usages des débuts de l’histoire d’une technologie perdent leur pertinence lorsque les mécanismes de structuration sociale commencent à se faire sentir. Plusieurs signaux laissent penser que nous y sommes.

L’intention « rassuriste »

On mesure donc à quel point l’idée de contrôle de l’outil, présupposée par la vision instrumentale de l’IA, est problématique. D’une part, une technologie comme l’IA « fait » beaucoup plus que la seule intention de ses utilisateurs finaux : elle les guide, les contraint, les rend dépendant, ouvre des possibles et en ferme d’autres, absorbe des compétences, etc. D’autre part, ses effets sociaux ne se réduisent pas à ce que ses utilisateurs en font, ne serait-ce que par les effets qu’elle produit même chez ceux qui ne l’utilisent pas, comme on vient de le voir. D’ailleurs, et sans s’inquiéter de la contradiction, les tenants des discours présentant les IAg comme de simples outils, s’accordent généralement pour affirmer que ces technologies « changent radicalement le monde » dans lequel on vit. Prendre cette affirmation au sérieux implique de réviser largement l’idée qu’elles seraient de « simples outils », puisque l’on comprend bien que « changer le monde » implique une dynamique autrement plus complexe que la simple somme des usages finaux.

La vision instrumentale des IAg porte avec elle une forme de « rassurisme » sur la capacité de contrôle et de maîtrise que les usagers finaux peuvent avoir des objets techniques.

Que ce « rassurisme » soit intentionnel ou qu’il soit l’effet d’une vision naïve de la technique, le résultat est le même : il participe de la banalisation – voire de la promotion – de cette technologie, nous empêchant de penser la complexité de ses effets et d’adopter les mesures appropriées. Il s’inscrit également dans un discours plus global sur l’inéluctabilité de cette technologie, lequel nous affirme qu’elle est « déjà-là » et que « la question n’est plus de savoir s’il faut s’opposer, mais comment on va vivre avec »22, produisant un sentiment de résignation et de totale impuissance. L’idée est en somme que nous n’avons d’autre choix que de nous adapter, mais qu’il n’y a pas de raison d’avoir peur du futur que cette technologie nous bâtit.

La vision instrumentale des IAg porte avec elle une forme de « rassurisme » sur la capacité de contrôle et de maîtrise que les usagers peuvent avoir des objets techniques.

Il faut par ailleurs relever le paradoxe suivant : les promoteurs de ces technologies et les patrons de la Big Tech, qui n’ont de cesse d’affirmer qu’il ne s’agit que d’« outils », soutiennent également que l’IA représente un « risque existentiel » pour l’humanité et qu’il est urgent de réglementer ce secteur. Comme le montre Thibault Prévost23, le paradoxe se résout lorsque l’on découvre l’intention qui anime les tenants de ces discours apocalyptiques, qui visent à prendre intégralement en main le devenir de ces technologies : l’IA est trop complexe et trop dangereuse, laissez-nous faire.

Comment tenir une critique radicale du « rassurisme » sans céder aux discours apocalyptiques qui nous maintiennent dans un état d’aveuglement quant aux dimensions matérielles et sociales décrites précédemment ?

Il s’agirait de penser lucidement ce que l’on perd et ce que l’on gagne au déploiement de ces technologies, pas seulement en tant qu’utilisateur, mais aussi en tant que société. On ne peut évidemment pas prédire comment les IAg transformeront la société et les individus qui la composent, il n’existe pas de déterminisme technique absolu, mais on peut néanmoins anticiper certains effets indésirables et s’organiser dès à présent pour tenter de les contenir.

Prenons un exemple : le principe de la génération automatique de texte, qui constitue la fonction élémentaire des IAg, transforme le rapport à l’écriture d’un texte24. Or, l’écriture est une activité fondamentale pour le développement de certaines capacités cognitives : esprit de synthèse, logique argumentaire, réflexivité, etc. Que penser d’une technologie qui développe la compétence « écrire le bon prompt » au prix de l’élimination du processus cognitif si singulier que constitue le passage de la pensée à l’écrit ? Comme le formulent efficacement deux enseignant·es : « on nous propose donc de nous libérer de la condition même de notre émancipation »25. Comment s’assurer du maintien et même du développement des compétences d’écriture sans assistance d’une IAg, quand bien même celle-ci serait plus « efficace » pour les réaliser ? En pédagogie comme ailleurs, ce n’est pas la destination qui compte mais le voyage, ce n’est pas le résultat mais l’expérience vécue pour le produire. Il s’agirait donc de faire l’inventaire de ce que l’on pourrait perdre avec la généralisation des IAg et auquel on tient pourtant, pour trouver les moyens de le conserver.

Lire aussi sur Terrestres : Gérard Dubey et Alain Gras, « Transition numérique : pour continuer comme avant », mai 2021.

Ces considérations ne concernent pas le seul domaine de la pédagogie et de l’apprentissage. Parmi ce que les individus pourraient perdre avec les IAg, figure aussi le sens qu’ils trouvent dans certaines de leurs activités. Dans une société où la valeur d’une activité humaine se mesure à son utilité et à l’efficacité avec laquelle elle est réalisée, les IAg représentent un moyen additionnel au service de cette logique. Par-delà les conséquences environnementales et sociales d’une telle perspective, se profile un risque de perte de sens. Comme le suggérait Hannah Arendt, « l’utilité instaurée comme sens engendre le non-sens »26.

Il existe une forme particulière de dépendance à la technologie, déjà largement constatée avec les smartphones, les réseaux sociaux et le numérique en général : l’addiction des individus à ces technologies.

Donnons un dernier exemple d’un effet indésirable, duquel il serait souhaitable de se préserver : l’addiction aux IAg. Il existe en effet une forme particulière de dépendance à la technologie, déjà largement constatée avec les smartphones, les réseaux sociaux et le numérique en général : l’addiction des individus à ces technologies. Ce phénomène, qui tient sans doute en partie à certaines propriétés de l’artefact, est savamment entretenu et amplifié par divers aspects de son design visant à maximiser le « taux d’engagement » des utilisateur·ices. Malgré leur arrivée récente, les IA génératives sont déjà largement utilisées comme compagne ou compagnon virtuel, entraînant des situations de dépendance affective considérablement plus puissantes qu’avec d’autres dispositifs numériques27. C’est dès aujourd’hui qu’il conviendrait d’imaginer et de mettre en œuvre des moyens de réduire ces risques d’addiction (en bridant d’une manière ou d’une autre ces technologies et leurs usages), et pas le jour éventuel où, comme avec « les écrans », le verrouillage socio-technique se trouve doublement cadenassé par des phénomènes addictifs.

Le problème des discours « rassuristes » est que non seulement ils évacuent des problématiques dont il serait nécessaire de débattre, mais en outre, en propageant un cadre d’analyse des effets sociaux des technologies totalement inadapté, puisque reposant sur une vision instrumentale, ils sapent les possibilités même d’un débat éclairé. Les discours « rassuristes » contribuent à nous maintenir dans cet état de « somnambulisme technologique » décrit par le philosophe Langdon Winner28.

Savoir contrer la « rhétorique de l’outil »

Au terme de ce parcours, sommes-nous mieux « outillé·es » pour démentir l’affirmation selon laquelle « ChatGPT, c’est juste un outil », comme nous en formulions l’intention en introduction ?

Si l’occasion se présente, on pourra commencer par rappeler les conditions de possibilité de ChatGPT, qui sont totalement invisibilisées par ce discours, et qui montrent qu’il s’agit plus d’un système complexe que d’un simple outil.

Ensuite, il pourra être utile d’exposer une brève histoire du développement de l’automobile, qui illustre le phénomène de dépendance au sentier. Celle-ci pourra être suivie par quelques exemples de pratiques sociales pour lesquelles l’usage du numérique est aujourd’hui incontournable, afin de souligner le fait que les futurs usages et effets de ChatGPT ne seront pas simplement un reflet étendu et amplifié des usages actuels et de ce qu’on peut constater de leurs effets.

La question n’est pas tant de savoir si tel usage est « pratique » ou pas, mais de déterminer si l’on souhaite contribuer à ce système et au monde qu’il façonne.

Enfin, on pourra faire remarquer l’intention « rassuriste » de ce discours, particulièrement inadaptée pour mener un débat éclairé sur ces technologies porteuses d’enjeux considérables. La question n’est donc pas tant de savoir si tel usage particulier est « pratique » ou pas, mais de déterminer si l’on souhaite contribuer à ce système et au monde qu’il façonne, pour pouvoir bénéficier de ce côté « pratique ».

Il faut sans doute se préparer à s’entendre dire : « la question n’est plus de savoir comment s’opposer à ChatGPT mais plutôt comment vivre avec ! »29. Cette phrase ne saurait clôturer le débat. Les deux postures, celle consistant à s’opposer (de manière raisonnée et circonstanciée) à l’IA et celle cherchant à « vivre avec », ne sont pas contradictoires. Nos sociétés sont traversées de dynamiques néfastes auxquelles on s’oppose tout en cherchant à vivre avec : des inégalités, des discriminations, des rapports de domination, des pollutions, des dégradations environnementales, des déséquilibres planétaires, etc. Le risque étant que, parce qu’elles sont considérées comme un simple « outil », les IAg continuent d’être adoptées de façon irraisonnée, et viennent renforcer ces dynamiques néfastes.

L’auteur remercie Guillaume Carbou pour les discussions stimulantes et les suggestions judicieuses.

Image d’accueil : photo de Manuel sur Unsplash.

NOUS AVONS BESOIN DE VOUS !

Depuis 2018, Terrestres est la revue de référence des écologies radicales.

À travers des essais, enquêtes, traductions inédites et récits de résistances, nous explorons les nouvelles pensées et pratiques nécessaires pour répondre à la catastrophe écologique.

Chaque semaine, nous publions en accès libre des articles qui approfondissent les enjeux écologiques, politiques, et sociaux, tout en critiquant l’emprise du capitalisme sur le vivant. Plus qu’une revue, Terrestres est un laboratoire d’idées et un lieu de réflexions critiques, essentielles à l’élaboration d’alternatives justes et émancipatrices.

En nous lisant, en partageant nos articles et en nous soutenant, par vos dons si vous le pouvez, vous prenez le parti de l’écologie radicale dans la bataille culturelle qui fait rage.

Merci ❤️ !

Notes

- Les IA génératives constituent un type particulier de système d’Intelligence Artificielle, destiné à générer du texte, des images, des sons, sur la base d’un modèle de langage large (LLM pour Large Language Model) entraîné sur un vaste corpus de données.[↩]

- On peut lire cette assertion dans des contextes aussi variés que des chartes d’utilisation de l’IA à l’Université (voir celle de l’Université Orléans, de l’Université de Franche Comté, dans le projet de charte élaboré par EdTech France), un dossier spécial IA du « programme national d’éducation au numérique des jeunes et des familles » et dans d’innombrables articles de presse et posts sur les réseaux sociaux qui proposent des astuces pour tirer « le meilleur parti de ces outils ».[↩]

- Alain Gras, Les macro-systèmes techniques, Que Sais-Je ?, PUF, 1997.[↩]

- Hans Jonas, Le principe responsabilité, Une éthique pour la civilisation technologique, 1979 [1990].[↩]

- « This is the state of play in the global data centre gold rush », Weforum, avril 2025.[↩]

- « Data centres will use twice as much energy by 2030 — driven by AI » Nature, avril 2025. Voir également « Les géants du numérique se convertissent au nucléaire… » (Le Monde, septembre 2024) au sujet de la relance et du développement du nucléaire pour répondre à ces nouveaux besoins en électricité.[↩]

- Voir notamment Camille Morel, « Les câbles sous-marins », CNRS éditions, 2023, sur les enjeux qui entourent ces infrastructures de l’Internet.[↩]

- Celia Izoard, « L’esprit qui dévorait la matière », Ecologie & Politique, 2024.[↩]

- On peut se référer sur ces sujets au séminaire du groupe de travail Matérialité du Numérique du Centre Internet et Société.[↩]

- Voir par exemple les travaux conjoints de l’ADEME et de l’ARCEP sur l’estimation de l’empreinte environnementale du numérique.[↩]

- Julien Pillot, Pourquoi la bulle de l’IA ne devrait pas éclater… malgré des inquiétudes légitimes, The Conversation, décembre 2024.[↩]

- Voir par exemple la progression de NVIDIA, leader des calculateurs dits GPU : « Nvidia, une progression fulgurante… », Le Monde, 27 février 2025.[↩]

- The impact of Artificial Intelligence on productivity, distribution and growth, rapport OCDE, 2024.[↩]

- Voir Antonio Casilli, En attendant les robots. Enquête sur le travail du clic, Seuil, 2019, et pour une référence plus récente spécifiquement sur le travail de modération du modèle de ChatGPT, l’article de Billy Perrigo dans le Time (18 janvier 2023) au sujet de l’exploitation de travailleurs kenyans.[↩]

- Sébastien Broca, Pris dans la toile. De l’utopie d’Internet au capitalisme numérique, Seuil, 2025.[↩]

- Voir « Pourquoi les images de ChatGpt imitant le studio Ghibli font polémique », Le Monde, 31 mars 2025 et « Intelligence artificielle : Meta poursuivi en France pour violation des droits d’auteur », 12 mars 2025.[↩]

- Contrairement à ce que l’on pourrait spontanément penser, la dissuasion nucléaire, qui agit par définition en l’absence d’usage à proprement parler, ne viole pas directement ce principe. L’usage de la technologie consistant dans ce cas à développer des armes nucléaires et à informer ses voisins qu’on est prêt à s’en servir.[↩]

- Pour donner un autre exemple récent parmi des tant d’autres, le tarif préférentiel pour les 12-26 ans sur les trains régionaux de la région Occitanie, dit +=0, requiert nécessairement la possession d’un smartphone, une application devant être activée à chaque montée et descente du train.[↩]

- Au point d’ailleurs que le fonctionnement de celles-ci en dépende, on sait les perturbations et blocages qu’entraînent une cyber-attaque ou une coupure d’Internet.[↩]

- Un « prompt » désigne la question ou la commande transmise à une IAg, l’équivalent d’une requête sur un moteur de recherche.[↩]

- Rappelons que ChatGPT n’a été proposé au grand public que fin 2022.[↩]

- « À l’heure des IA, la révolution silencieuse des examens : « La question n’est plus de savoir s’il faut s’opposer, mais comment on va vivre avec » », Le Monde, 8 avril 2025.[↩]

- Thibault Prévost, Les prophètes de l’IA. Pourquoi la Silicon Valley nous vend l’apocalypse, Lux, 2024.[↩]

- Voir par exemple « l’expérience d’écriture » relaté par le philosophe italien Andrea Colamedici, qui se présente comme le traducteur de Jianwei Xun, un auteur fictif. Le livre « Hypnocratie » (PhiloMag, 2025) a en effet été écrit en interagissant avec diverses IAg. Avec un style et des analyses concernant la facticité de notre rapport au monde qui rappellent celles des penseurs situationnistes, l’ouvrage peine à convaincre de la solidité de ses concepts. Le fait que certain·es y aient vu l’œuvre « de l’un des plus brillants philosophes de sa génération » devrait les faire réfléchir à leur propension à se laisser hypnotiser par des discours artificiels.[↩]

- « L’IA, junk food de la pensée | Academia », Christophe Cailleaux et Amélie Hart.[↩]

- Dans La condition de l’Homme moderne, 1958.[↩]

- Voir l’étude du MIT : « AI companions are the final stage of digital addiction ». Cette étude mentionne notamment un projet de loi adopté dans l’état de Californie pour limiter les « fonctionnalités addictives » des ChatBot et qui autorise les utilisateurs à poursuivre les entreprises opérant ces systèmes si un tort leur est causé par l’usage d’un ChatBot qui ne respecterait pas la réglementation (voir « Kids are talking to AI companions », Washington Post, 1er avril 2025).[↩]

- Langdon Winner, « La baleine et le réacteur », 1986.[↩]

- Conclusion de la chronique « un monde connecté » par le journaliste François Saltiel, le 8 mai 2025, France Culture. De façon ironique, celle-ci était consacrée à l’amplification des inégalités sociales par ChatGPT (la question étant donc, si l’on en croit le journaliste, de savoir comment vivre avec).[↩]